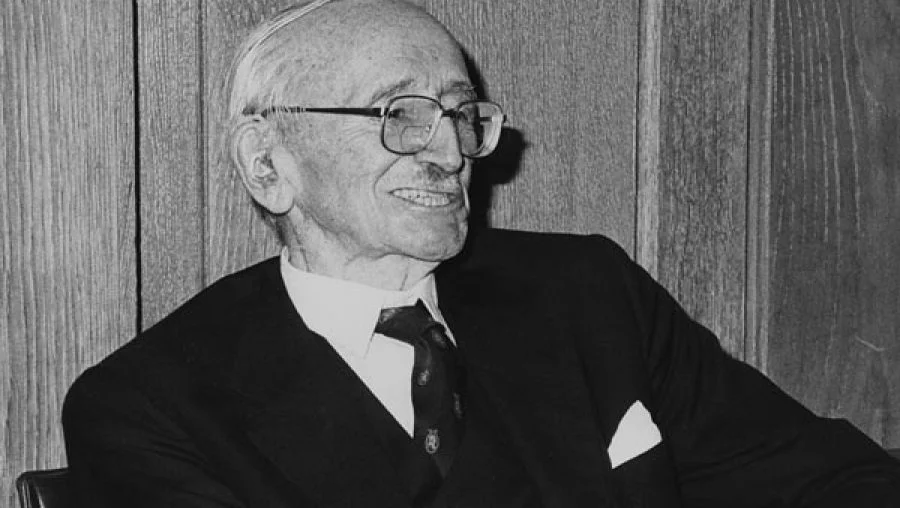

Le 12 septembre 2011, lors d’une conférence à Munich, l’économiste en chef du groupe Deutsche Bank, Thomas Mayer, un des économistes les plus réputés du secteur financier au plan mondial, a surpris son auditoire en déclarant être “un Autrichien en économie”. Contrepoints vous propose une traduction de cette passionnante conférence dans laquelle T. Mayer explique en quoi les théories autrichiennes sont beaucoup plus pertinentes que les théories keynésiennes ou la théorie des anticipations rationnelles pour expliquer les différentes crises que le monde occidental a connu depuis les années 30 jusqu’à la situation actuelle.

Par Thomas Mayer

Résumé

Cet article est basé sur une conférence donnée par l’auteur le 12 septembre 2011 à Munich. Il développe les points suivants :

— L’échec des « liquidationnistes » à venir à bout de la Grande dépression du début des années 1930 a ouvert la voie à une ère d’interventionnisme économique. Les macroéconomie et finance modernes ont été bâties sur la croyance que nous pouvions prévoir avec certitude le futur. Mais la crise actuelle nous apprend que nous vivons dans un monde d’incertitude de Knight, où les « inconnues inconnues » dominent et où nos plans pour le futur sont régulièrement contrariés par des événements imprévus et imprévisibles.

— Dans un monde d’incertitudes de Knight, les investisseurs et les institutions financières ont besoin de plus de marges pour faire face aux imprévus, i.e. plus de fonds propres et moins d’utilisation d’effets de levier

— Dans un monde où les marchés ne sont pas parfaitement liquides mais où ils peuvent se figer dans des accès de panique, les institutions financières et les investisseurs ont besoin de plus de liquidités.

— La législation peut nous aider à atteindre ces deux objectifs, mais elle doit avoir conscience de ses limites. Tout d’abord, les entreprises doivent être incitées à avoir des pratiques raisonnables. La meilleure motivation est de rendre possible la faillite. Nous avons donc besoin d’un système de liquidation des entreprises financières rapide et efficace.

— Dans un monde où les agents économiques n’ont qu’une vision imparfaite du futur et ne se comportent pas toujours de manière rationnelle, dans un monde où les marchés ne sont pas forcément efficients, nous devons accepter le fait que les politiques économiques ne peuvent faire disparaître les cycles.

— Pour nous autres économistes, la principale leçon des événements récents est que nous devons moins nous appuyer sur des théories déductives (comme les sciences physiques) et plus sur l’induction (comme les sciences sociales). L’incapacité à étudier l’histoire nous conduit à répéter les erreurs du passé.

—-

Introduction

La crise financière a conduit de nombreuses personnes à douter des mérites des marchés libres et du régime économique libéral. Ils accusent les marchés d’en être responsables et demandent aux gouvernements plus de régulation et de planification centralisée. Nous allons démontrer que tant l’analyse qui soutient cette position que la politique qui en découle sont des erreurs. Cette crise a été causée par une trop grande confiance en l’efficacité des planifications financière et économique. L’incapacité des « liquidationnistes » à venir à bout de la Grande dépression des années 1930 a favorisé l’apparition d’une ère d’interventionnisme économique. La finance et la macroéconomie modernes ont nourri l’idée que nous étions capables de planifier avec succès l’avenir. Cependant, la crise actuelle nous apprend que nous vivons dans une monde d’incertitude de Knight [1], où les “inconnues inconnues” dominent et où nos plans futurs sont régulièrement contrecarrés par des événements imprévus et imprévisibles. Nous avons été victimes de “l’illusion de contrôle”. Nous avons besoin de reconnaître les limites de la planification et la supériorité d’un ordre économique libéral où les États, les sociétés et les individus doivent être tenus pour responsables de leurs décisions.

Le précédent de la crise actuelle

Afin de développer notre argumentation, nous allons tout d’abord étudier brièvement le précédent de la crise financière actuelle : la dépression des années 1930. Durant les années 1920, l’abondance de l’offre monétaire et une appétence exagérée pour le risque, mise en évidence par un effet de levier extrême dans les fonds d’investissement les plus populaires, ont favorisé l’émergence d’une bulle spéculative sur le prix des actions. Quand finalement l’offre monétaire s’est durcie, tout l’édifice fondé sur les effets de levier s’est écroulé et les marchés boursiers se sont effondrés en octobre 1929.

À cette période, les autorités ont assumé le choc. Beaucoup de politiciens pensaient que ce crash et la possible récession qui en découlait étaient nécessaires pour corriger les excès et les déséquilibres nés dans Années Folles. Adrew Mellon, alors secrétaire du Trésor américain, a résumé cette position en disant :

[…] Liquidez le travail, liquidez les actions, liquidez l’agriculture, liquidez les biens immobiliers… cela purifiera ce système gangrené. Les coûts de la vie excessifs de même que les trains de vie se réduiront. Les gens travailleront plus dur, vivront une vie plus morale. Les valeurs seront ajustées et les entrepreneurs prendront la relève des incompétents.” (Hoover, Herbert (1952). Mémoires. Hollis and Carter, p30)

Inspirés par l’attitude de Mellon, ceux qui pensaient aussi que la récession était une “purification” du système furent plus tard désignés sous le nom de “liquidationnistes”.

Ceux-ci purent justifier leurs opinions à l’aide de la théorie développée par l’école d’économie autrichienne, notamment par Joseph Shumpeter, et puis surtout par Friedrich von Hayek, lequel a basé sa théorie des cycles économiques sur les travaux de l’économiste suédois Knut Wicksell. Wicksell faisait la distinction entre un taux de rendement “naturel”, qui reflète les retours sur investissement, et un taux d’intérêt “de marché”, qui découle des coûts d’emprunt facturés par les banques. Lorsque le taux de marché est sous le taux naturel, les entreprises empruntent pour investir et l’économie croît. Dans le cas contraire, l’investissement est réduit et l’économie se contracte.

L’école autrichienne a utilisé ce principe pour développer une théorie des cycles économiques accordant une place capitale aux cycles du crédit (cf. graphique). Les taux d’intérêts bas favorisent l’emprunt auprès du système bancaire. Ceci en retour crée une intenable explosion de l’investissement à crédit durant laquelle l’emprunt “artificiellement stimulé” cherche à diminuer les opportunités d’investissement. Ce boom a pour conséquence un surinvestissement généralisé dans lequel le capital est mal investi, notamment dans certains secteurs dans lesquels nul n’aurait investi si l’offre de crédit avait été stable. Cette expansion devient récession lorsque la création de crédit ne peut être maintenue, que ce soit à cause d’une augmentation des taux du marché ou d’une diminution du taux naturel par exemple, et un “credit crunch” se met en place. L’afflux de monnaie se contracte violemment et rapidement dès lors que les marchés commencent à se “purifier”, amenant les ressources à être réallouées plus efficacement [2].

L’école autrichienne a utilisé ce principe pour développer une théorie des cycles économiques accordant une place capitale aux cycles du crédit (cf. graphique). Les taux d’intérêts bas favorisent l’emprunt auprès du système bancaire. Ceci en retour crée une intenable explosion de l’investissement à crédit durant laquelle l’emprunt “artificiellement stimulé” cherche à diminuer les opportunités d’investissement. Ce boom a pour conséquence un surinvestissement généralisé dans lequel le capital est mal investi, notamment dans certains secteurs dans lesquels nul n’aurait investi si l’offre de crédit avait été stable. Cette expansion devient récession lorsque la création de crédit ne peut être maintenue, que ce soit à cause d’une augmentation des taux du marché ou d’une diminution du taux naturel par exemple, et un “credit crunch” se met en place. L’afflux de monnaie se contracte violemment et rapidement dès lors que les marchés commencent à se “purifier”, amenant les ressources à être réallouées plus efficacement [2].

Au lendemain de la crise de 1929, l’approche liquidationniste, dont Mellon devint le symbole, avait accepté comme inévitable le ralentissement économique du début des années 1930. Ce qui n’avait pas été vu était qu’une extrême aversion au risque pouvait maintenir le taux du marché au dessus du taux naturel même après que la “gangrène” ait été « purgée du système ». Franklin D. Roosevelt, qui avait battu Hoover lors de la présidentielle de 1932, semblait avoir intuitivement compris ce problème. Peut-être que la plus importante décision qu’il prit peu après son investiture en 1933 fut de garantir les dépôts. La conséquence de ce choix fut que tout l’argent que les gens avaient gardé sous leur matelas a été ramené vers les banques, améliorant ainsi leur liquidité. Lorsque, peu après, l’administration Roosevelt recapitalisa les banques, l’extension du crédit recommença et l’économie redémarra. Il est intéressant de noter qu’il n’y a pas eu de grande politique de relance en 1933, les effets du célèbre New Deal n’apparurent que bien plus tard. Donc, contrairement à l’idée répandue, l’étincelle qui causa la reprise économique de 1934 fut bien l’inversion du cycle de crédit (cf. graphique).

Avoir vécu la dépression et la reprise sous Roosevelt a incité John Maynard Keynes à lancer une violente attaque contre l’école autrichienne. Avec sa Théorie Générale, écrite en 1935, il s’était fait l’avocat de l’interventionnisme étatique. Pour lui, la politique budgétaire devait être adaptée lorsque les gens craignent la déflation et thésaurisent à outrance. Beaucoup d’étudiants en économie croient aujourd’hui encore que l’application de la théorie de Keynes a mis un terme à la récession des années 1930-1933. Nous ne sommes pas de cet avis. D’après notre lecture de ces événements, seule la politique visant au retournement du cycle de crédit a mis un terme à cette récession. Par conséquent, la reprise de 1934 fut plus autrichienne que keynésienne. Soyons clair : les liquidationnistes avaient tort de laisser la dépression se développer sans voir que la peur engendre la peur. Roosevelt l’avait compris lorsqu’il affirma dans son discours d’investiture que “la seule chose que nous ayons à craindre est la peur elle-même”; et il a eu raison d’intervenir et de stabiliser le système bancaire. Mais ce qu’il fit, à savoir ouvrir les marchés du crédit, est exactement ce qu’il faut faire selon la théorie autrichienne des cycles économiques.

Les économistes autrichiens avaient prévu qu’une politique conduisant à l’extension du cycle de crédit avant que tous les excès de l’économie n’aient été corrigés ne ferait que reporter le début de la reprise. Mais ils étaient également obligés de reconnaître qu’après la dépression de 1930-1933 il restait bien peu “d’excès” dans l’économie des pays occidentaux. Néanmoins, l’économie se contracta de nouveau en 1937 lorsque les politiques monétaire puis budgétaire furent interrompues. La plupart des historiens affirment que cette période d’instabilité économique vécue par les États-Unis ne se termina qu’à la fin des années 1930, lorsque le pays se préparait à la guerre. L’historien britannique Niall Ferguson a même affirmé que si l’Allemagne était sortie de la dépression avant les États-Unis, c’est parce qu’elle se préparait bien avant, et de façon plus marquée, à la Seconde Guerre mondiale. Il semble que seule l’anticipation de la guerre a conduit la “peur de la peur” à cesser d’être un facteur économique déstabilisant.

Cette relecture de la Grande dépression nous amène à une conclusion assez dérangeante : la théorie autrichienne des cycles de crédit semble bien mieux convenir aux événements réels que la théorie de Keynes de la trappe à liquidités et du pouvoir des politiques budgétaires (cf. graphique ci-dessous). Ce que les économistes autrichiens semblent avoir manqué est qu’une économie paralysée par une aversion extrême au risque peut avoir besoin d’un coup de fouet, ce dernier consistant en des politiques ayant pour but de restaurer la confiance. Mais ceci n’est malheureusement pas ce que la plupart des économistes et politiciens ont conclu.

Les leçons de la Grande dépression : la mainmise des États

À la fin de la Seconde Guerre mondiale, nombre d’intellectuels et d’économistes occidentaux ont flirté avec la planification centrale à la soviétique. Après tout, l’URSS avait connu une ère prospère dans les années 1930, alors que les pays capitalistes étaient en crise. Cela ne prouvait-il pas la supériorité de ce modèle ?

Ayant perdu le combat intellectuelle contre Keynes et ses disciples, les économistes autrichiens ont livré un baroud d’honneur contre la planification avec l’ouvrage de Hayek, La Route de la Servitude, publié en 1946. Ils gagnèrent là la bataille des principes et le monde occidental ne succomba pas à la tentation du dirigisme étatique, et ce malgré l’attrait certain de ce modèle sur beaucoup d’intellectuels d’après guerre. Keynes lui-même se rangea du côté des économistes autrichiens, sur les principes généraux, et écrivit à Hayek:

Selon moi, il s’agit d’un grand ouvrage […] Moralement et philosophiquement, je suis en accord avec quasiment la totalité de ce livre : et il ne s’agit pas d’un simple accord mais d’un parfait et total accord.

Néanmoins, les économistes autrichiens avaient perdu la bataille des idées concernant les politiques économiques à mener dans les pays occidentaux après-guerre. L’idée keynésienne de “relance par la demande” via les politiques budgétaires devint en effet le credo des économistes. Même Nixon, qui rompit le lien entre l’or et le dollar en 1971, est réputé avoir dit : “Je suis maintenant keynésien”.

Des années 1950 à la fin des années 1970, les politiciens occidentaux ont usé et abusé des politiques budgétaires en tant qu’outils de politique économique. Les gouvernements ont été enthousiastes à l’idée d’augmenter l’offre de crédit lors des récessions économiques, mais généralement plus réticents à l’idée de la diminuer lors des reprises. Jusqu’à la fin des années 1960, l’usage excessif des politiques budgétaires a lourdement contribué à la dégradation des finances des États, qui ne pouvait trouver de solution que dans la monétisation des dettes souveraines. C’est pour cela que le 15 août 1971 Richard Nixon a suspendu la convertibilité du dollar en or, créant ainsi le système actuel de monnaie fiat.

Après-guerre, durant la période d’utilisation implicite de l’étalon-or exigé par le système de Bretton-Woods (lorsque le dollar américain était supposé aussi sûr que l’or), il y avait fort peu de marges de manœuvre pour les politiques monétaires proactives – ce qui n’a pourtant pas empêché le gouvernement américain d’utiliser la planche à billet comme source de financement secondaire. Cela a changé dramatiquement après la décision de Nixon de 1971. La conséquence fut une inflation significative, puisque la dette et les déficits gouvernementaux étaient en partie financés par la planche à billets. Le mot de “stagflation” fut alors inventé pour décrire la situation économique des années 1970, mélange de stagnation économique et d’inflation.

La mainmise des banques centrales

La raison de l’échec de ce nouveau système de monnaie fiat est qu’il lui manquait une “ancre monétaire”. Ceci a eu pour conséquence le développement de politiques budgétaires et salariales laxistes. Cela fut en partie reconnu par les politiciens du début des années 1980. Au cours des années 1970, Milton Friedman avait proposé de limiter l’expansion de la quantité de monnaie et avait préparé l’introduction de banques centrales indépendantes. Alors que la stagflation mit un terme à l’idée selon laquelle il y avait une relation négative entre inflation et chômage, l’ère du monétarisme arriva. Le directeur de la Réserve Fédérale Volcker profita de la recommandation monétariste de “contrôler l’offre de monnaie” pour justifier la mise en place d’une profonde récession qui diminua drastiquement l’inflation. Ainsi, le début des années 1980 fut une période de repentance des péchés keynésiens commis dans les années 1960 et 1970. Avec le développement de la théorie des anticipations rationnelles et des marchés financiers efficients, la balance sembla ne plus pencher vers le constructivisme mais au contraire vers un régime plus libéral.

Mais les bornes imaginées par Friedman pour contenir les politiques monétaires ne tinrent pas longtemps. Au milieu des années 1980, la politique monétaire se libéra du carcan friedmanien et devint proactive. Le grand champion de cette approche fut Alan Greespan, qui succéda à Volcker en 1987.

Le crack boursier de 1987 fut l’occasion d’appliquer pour la première fois une politique monétaire proactive. Afin d’éviter une récession, Greenspan diminua drastiquement les taux d’intérêt. Le remède fonctionna et la fin des années 1980 vit non pas une récession mais une croissance de l’économie. La seconde occasion d’utiliser la “méthode Greenspan” vint avec la crise du crédit de la fin des années 1980, qui contribua à la récession de 1990-1991. Une fois encore, Greenspan et la Fed abaissèrent de façon sensible les taux d’intérêts et, une fois de plus, réussirent à atténuer le ralentissement économique. Dans les années qui suivirent, la méthode Greenspan fut employée encore afin de combattre les marchés émergents asiatiques et la crise LTCM [3] de 1998, et une fois de plus lors de l’éclatement de la bulle internet de 2000-2002. Jusqu’à la grande crise financière de 2007, il semblait que la méthode Greenspan, à savoir l’usage proactif de la politique monétaire afin de moduler l’évolution de l’économie, avait réussi à mettre un terme à l’existence des cycles financiers tels que nous les connaissions. Grâce à l’art des gouverneurs de Banques centrales, l’ère de la Grande Modération était arrivée.

La grande crise économique qui débuta en 2007 révéla la Grande modération comme étant… une grande illusion. Néanmoins, les vieux réflexes conduisirent à l’utilisation combinée de politiques monétaires et budgétaires d’une ampleur jusque-là inégalée. Alors que les excès causés par l’illusion de la Grande Modération n’étaient pas encore corrigés, la crise se déplaça du secteur des crédits « subprimes » américains aux marchés monétaires, puis au système bancaire, pour s’étendre plus récemment au secteur public. Le principe a été de déplacer l’impressionnant fardeau de la dette des épaules faibles aux solides, et de réduire le service de la dette via une politique monétaire de taux bas. Mais durant ce processus, ceux qui étaient autrefois solides ont été affaiblis. Quelque part, il semble que la vieille ruse ait échoué, et la crise engendrée par un massif deleveraging semble devenir incontrôlable.

La théorie qui sous-tend le “Greenspanisme”

Quelle fut la faille majeure qui nous a entraînés vers cette crise ? À notre avis, la croyance que, même dans un monde empli d’incertitudes, les résultats économiques et financiers peuvent être prédits. Les hypothèses d’anticipations rationnelles et d’efficience des marchés ont placé une confiance imméritée dans la capacité des décideurs politiques, des entreprises et des agents économiques à planifier efficacement l’avenir en dépit des inconnues omniprésentes.

Au niveau macroéconomique, la théorie des anticipations rationnelles et des marchés efficients a préparé le terrain d’une focalisation sur l’inflation des principales banques centrales, à la place de la focalisation monétaire du début des années 1980. L’on s’attendait à voir l’économie croître de manière satisfaisante, pourvu que les banques centrales garantissent une inflation des prix à la consommation stable et peu importante. Cette confiance aveugle dans le pouvoir des banques centrales a amené Paul Krugman à affirmer à la fin des années 1990 :

Si vous voulez un modèle simple vous permettant de prédire le taux de chômage des prochaines années, le voici : il sera ce que Greespan veut qu’il soit, plus ou moins epsilon car il n’est pas tout à fait Dieu.

Lorsque les individus sont mus par des anticipations rationnelles et que les marchés sont efficients, nul besoin de s’inquiéter du marché des actifs ou de réguler les marchés financiers. Après tout, comment les banques centrales et les régulateurs peuvent-ils en savoir plus que le marché alors que les prix reflètent la totalité de l’information disponible ? Celui qui questionnait la sagesse de ce paradigme était considéré comme réactionnaire par le collège des cardinaux de l’Église de l’économie Anglo-Saxonne, qui régnait sans conteste possible. Avec le recul, il semble étrange que les universitaires aient ignoré l’obsession et le culte des marchés financiers à l’égard les banques centrales. Comment pouvaient-ils être à ce point suspendus aux lèvres des gouverneurs alors même qu’ils disposaient si efficacement de toute l’information disponible en temps réel ? Mais les économistes étaient trop énamourés de leurs propres théories pour s’intéresser à de telles bizarreries.

D’un point de vue microéconomique, la théorie des anticipations rationnelles et des marchés efficients a facilité la création de nombreux produits financiers à fort effet de levier et la gestion du risque. Les agents des marchés financiers n’avaient d’yeux que pour les “inconnues connues”, qui pouvaient être quantifiées de manière probabiliste. Dans ce monde “d’inconnues connues”, ils avaient la sensation de ne pas vraiment avoir besoin de se protéger de ce qui était vraiment imprédictible : les “inconnues inconnnues” [4]. Par conséquent, il semblait parfaitement logique d’étendre les effets de levier à l’extrême. Après tout, les risk managers pouvaient calculer continuellement et en temps réel la valeur des pertes potentielles en cas d’imprévu. La sensation de contrôler ce qui en résultait – c’est-à-dire d’être capable de prédire avec une assez bonne voire une parfaite certitude – a été la cause de l’utilisation massive d’effets de leviers extrêmes dans les produits financiers et les comptes des entreprises financières.

Après la disparition de cette illusion de contrôle

L’effondrement de ces théories nous force à réduire drastiquement l’usage des leviers financiers. Si nous ne pouvons pas prévoir les résultats possibles avec une relative précision, nous avons besoin de plus de marges de sécurité afin de nous couvrir contre les inconnues ; d’où cette diminution.

L’impuissance de la profession économique face à la crise actuelle est patente dans la recommandation de certains économistes d’inciter encore plus à l’utilisation d’effets de levier. Ils conseillent d’avoir une politique budgétaire expansionniste, de maintenir les taux directeurs à zéro pendant un long moment et de faire racheter des actifs financiers par les banques centrales.

Actuellement, celles-ci combattent la réduction de l’utilisation de leviers financiers par l’émission d’encore et toujours plus de monnaie. Tandis que l’outside money implose, l’inside money explose. Pour l’instant, l’objectif de réduire l’utilisation de leviers conduit à la diminution du prix des actifs et à la course à la liquidité. Mais plus les banques centrales réussissent à remplacer la réduction de l’outside money via une réduction des leviers financiers par une expansion de l’inside money, plus il est probable que l’on assiste à une monétisation des dettes.

La tentative désespérée d’éviter une crise économique causée par le nécessaire deleveraging pourrait mener à une crise de la monnaie fiat elle-même. Le 15 août dernier, le système de monnaie fiat a fêté son 40ème anniversaire. Depuis que Nixon a rompu le dernier lien entre le dollar et l’or en 1971, il s’est déprécié de 98% par rapport au métal jaune (cf. graphique). Cette dépréciation s’est déroulée en deux temps : tout d’abord dans les années 1970 lorsque le brusque afflux de dollars créés à la fin du système de Bretton Woods et au début du nouveau système de monnaie fiat a donné lieu à une importante augmentation de l’inflation ; dans un second temps après l’implosion de la « Grande modération » en 2007, lorsque les actifs pourris ont commencé à migrer du secteur privé au public via l’action des banques centrales.

La tentative désespérée d’éviter une crise économique causée par le nécessaire deleveraging pourrait mener à une crise de la monnaie fiat elle-même. Le 15 août dernier, le système de monnaie fiat a fêté son 40ème anniversaire. Depuis que Nixon a rompu le dernier lien entre le dollar et l’or en 1971, il s’est déprécié de 98% par rapport au métal jaune (cf. graphique). Cette dépréciation s’est déroulée en deux temps : tout d’abord dans les années 1970 lorsque le brusque afflux de dollars créés à la fin du système de Bretton Woods et au début du nouveau système de monnaie fiat a donné lieu à une importante augmentation de l’inflation ; dans un second temps après l’implosion de la « Grande modération » en 2007, lorsque les actifs pourris ont commencé à migrer du secteur privé au public via l’action des banques centrales.

Le jour où la monnaie fiat s’effondrera, elle pourrait bien être remplacée par une devise s’appuyant sur un actif réel, ne pouvant être augmenter d’un coup de crayon des gouverneurs de banques centrales. Comment cela pourrait-il arriver ? Une possibilité, qui actuellement est du domaine de la science-fiction, serait que la Chine et d’autres grands pays émergents fixent la valeur de leur monnaie sur un panier de biens de consommation. Ce serait alors aux pays industrialisés d’essayer de stabiliser leurs devises contre le Yuan, ou alors d’accepter l’inflation qui accompagne la dépréciation monétaire.

Conclusion

La macroéconomie et la finance modernes sont basées sur la croyance que les agents économique sont toujours guidés par des anticipations rationnelles et l’illusion que les marchés sont toujours efficients. En d’autre termes, elles sont basées sur l’hypothèse que la terre est plate. Nous savons maintenant que ces hypothèses sont fausses. Il y a une part d’irrationalité et d’inefficacité dans le comportement des agents économiques et des marchés. Par conséquent, nous devons abandonner ces théories “de la terre plate” qui nous affirment que les résultats économiques et financiers futurs peuvent être prédits avec quasi-certitude et nous tourner vers d’autres théories qui acceptent les limites de notre connaissance du futur. Une renaissance de l’école autrichienne pourrait être un bon départ pour un tel changement.

Malheureusement, le cri de bataille des politiciens et des électeurs est “toujours plus de régulation” : régulez les banques, régulez les marchés, régulez les produits financiers ! Mais ceux qui prônent cette orgie de régulations souffrent de la même illusion de contrôle que ceux qui nous ont plongés dans cette crise. À notre avis, nous n’avons pas besoin de plus de régulation mais d’une régulation plus intelligente. Au cœur d’une telle régulation se trouve la simple constatation que nous pouvons au mieux essayer de prévoir le futur et que nous devons avancer à tâtons, par essais et erreurs successives.

Dans un monde où nous devons vivre avec les “inconnues inconnues”, dans un monde ou l’incertitude de Knight règne, les entreprises financières et les investisseurs ont besoin de plus de marges de sécurité pour affronter l’imprévu, c’est-à-dire plus de fonds propres et moins d’utilisation d’effet de levier.

Dans un monde où les marchés ne sont pas toujours liquides mais au contraire peuvent se figer dans un accès de panique collective, les entreprises financières et les investisseurs ont également besoin de plus grandes réserves de liquidités.

Légiférer peut nous aider à atteindre ces deux objectifs, mais nous devons être conscients des limites de la loi. Les régulations créeront un sentiment de sécurité trompeur, à moins que les compagnies et investisseurs ne soient incités à avoir des comportements raisonnables. La meilleure façon d’y parvenir est de rendre la faillite possible. Nous avons donc besoin de régimes de liquidation efficaces pour les entreprises financières.

Dans un monde où les gens ont une connaissance imparfaite du futur, où ils n’agissent pas toujours de manière rationnelle, et où les marchés ne sont pas toujours efficients, nous devons accepter le fait que les politiques économiques ne peuvent éviter les cycles. Tout ce que la politique peut faire est de calmer les période d’exubérances ou de dépression durant les cycles de crédit et d’aider à éviter les excès de prises de risques irraisonnées auxquels nous avons assisté au cours de la dernière décennie. Il est inutile de manipuler préventivement les marchés afin d’atteindre certains objectifs économiques. Au lieu de cela, nous ferions mieux de chercher à créer les conditions favorables à un développement harmonieux du crédit en permettant au marché de se rapprocher autant que faire se peut du taux naturel. Lorsque des imprévus surviennent, nous devons empêcher la « peur de la peur » de prolonger les crises en nous assurant que le système bancaire soit capable de répondre à la demande de crédits.

Enfin, les économistes doivent savoir rester humbles. Pendant trop longtemps nous nous sommes pris pour des physiciens. Comme eux, nous aimons développer des théories déductives : poser quelques axiomes et décrire mathématiquement le monde à partir de ceux-ci. Cela était pour le moins présomptueux. Nous devons réaliser que nous sommes en grande partie des chercheurs en sciences sociales. Comme les historiens, les chercheurs en sciences sociales utilisent des méthodes inductives. Ils observent et après seulement ils tentent de décrire le monde, se basant sur ces observations. Parce que nous n’avons pas assez prêté attention à l’histoire économique et avons été extrêmement dépendants de nos modèles mathématiques, nous avons répété nombre des erreurs qui ont causé la Grande dépression.

—-

Traduction : MXI et Raphaël Marfaux pour Contrepoints.

Notes :

[note][1] NdT : Frank Knight (1885 – 1972) est un économiste principalement connu pour la distinction entre risque et incertitude qu’il propose en 1921 dans Risk, Uncertainty and Profit. L’incertitude de Knight décrit un risque qui n’est pas mesurable.

[2] Notez que Hyman Minsky, qui est généralement associé à l’école économique post-keynésienne, a décrit le cycle du crédit de façon similaire.

[3] NdT : Long Term Capital Management est un hedge fund apparu en 1994 et dont la quasi-faillite en 1998 fit courir un risque majeur au système bancaire international et créa des perturbations importantes sur les marchés financiers.

[4] Nous devons cette classification des incertitudes à Donald Rumsfeld, ancien secrétaire américain à la Défense, qui a lui aussi appris, durement, l’existence des “inconnues inconnues”.[/note]

Article intéressant et pertinent globalement même s’il y a des raccourcis et si certains points sont discutables.

Une critique : à mon avis, la grossière erreur de certains autrichiens est de considérer que parce qu’on ne peut pas avoir la totalité du contrôle, rien ne sert de chercher à contrôler quoi que ce soit. Du coup, ils critiquent toute forme ou recherche d’ingénièrie quelle qu’elle soit. Tout ce qui est mathématique est vouée aux gémonies. Or ce n’est pas parce qu’un modèle ou un outil n’est pas parfait qu’il est à jeter aux orties. Il peut rendre des services à un ou plusieurs individus dans telle ou telle situation précise.. Ce qui m’agace chez certains autrichiens, c’est ce rejet absolu des mathématiques et de la modélisation, qui mène à une impasse. Du coup, ils sont aussi criticables que ceux qui s’en remettent exclusivement aux mathématiques pour tout régler. La vérité est au milieu.

“la vérité est au milieu”

c’est là tout le tort, la vérité n’est pas au milieu, il n’y a qu’une seule vérité, prétendre que la vérité est au milieu c’est faire dans l’idéologie relativiste et molle que les autrichiens combattent et que trop souvent les keynesiens et les tenants de l’économie mathématique soutienne.

Les autrichiens considèrent que l’économie traitent des actions humaines et que celle-ci ne peuvent être réduites à des constantes mathématiques.

Les tenants de l’économie mathématique usent des méthodes expérimentales, issues de la physique et de la biologie, pour expliquer des phénomènes qui sont le produits d’action humaine. Cette méthodologie reléve d’une grande confusion epistémologique, car l’objet d’étude des sciences expérimentales est la matiére inerte, alors que celui de l’économie “autrichienne” est l’action humaine.

En fait user des moyens de la science expérimentale pour expliquer des phénomènes économiques n’a rien de scientifique, c’est au mieux du scientisme.

Tout à fait. L’économie est une science sociale, pas une science naturelle.

Et cela aboutit à ce que nos chers macro-économistes font de sacrés sophismes, en arrivent à inverser la causalité…

En discutant avec des keynésiens, on dirait qu’ils croient que l’activité humaine dépend de la croissance alors que c’est l’inverse, bon sang. C’est à croire que la croissance est une source mystique d’énergie à prospérité.

La macro-économie, en ne tenant pas compte du caractère individuel des acteurs économiques ne peut que sombrer dans le déterminisme.

Le scientisme, c’est confier aux formules le soin de valider les dogmes préconçus. Ces formules tautologiques, programmées à partir des prémisses fausses de leurs concepteurs, conduisent nécessairement à des résultats erronés. Il en va ainsi du multiplicateur keynésien ou de la mesure du risque bancaire. Mais rejeter sans distinction toute expérimentation mathématique en économie est exagéré. S’il n’est pas question de modéliser finement les comportements humains, il est possible de s’intéresser à leurs aspects les plus grossiers.

Bubulle a tout à fait raison.

A titre d’exemple, l’analyse technique (graphique et mathématique) de l’évolution des cotations des valeurs mobilières permet de prévoir l’évolution future à partir du comportement passé. Ces prévisions ont une probabilité de 60% à 80% de se réaliser, en fonction des marchés, des indicateurs utilisés, de la méthode d’analyse, et d’autres facteurs.

Ce type d’analyse est aussi applicable aux évolutions macroéconomiques et permet d’effectuer des prévisions avec un taux de réussite inférieur à 100%. Ceci ne nous permet pas d’être sûr du comportement futur des variables en jeu, mais permet de le prévoir avec une probabilité supérieure à 50%, ce qui est donc utile.

Je fais moi même de l’analyse de risque dans un domaine technique sans rapport avec la finance. Je peux vous dire que le grand danger des méthodes mathématiques est qu’afin de passer du monde réel au monde mathématique, il est nécessaire de faire des hypothèses qui sont souvent beaucoup trop fortes. Ces hypothèses seront justes la plupart du temps mais peuvent s’avérer fausses sur une période donnée, en particulier lors des évènements rares contre lesquelles on veut justement se prémunir. La première hypothèse souvent utilisée abusivement est l’indépendance des variables aléatoires. Par exemple, les cours des actions d’entreprises sans aucun rapport ne sont pas liés usuellement sauf en cas de krach ou de déprime global où les variations sont directement corrélées. Une deuxième hypothèse abusive est que les statistiques sont les mêmes aux différentes échelles. On applique alors les probabilité des 20 dernières années pour prévoir les évènements sur le prochain mois, ce qui peut être faux. Le bruit n’est pas toujours blanc. Une troisième hypothèse souvent erronée est le caractère gaussien des variables aléatoires. Sur le long terme, il est prouvé mathématiquement que les phénomènes additifs conduisent à des variables gaussiennes avec des lois normales, d’où l’illusion que tout est gaussien. Mais en réalité, certains phénomènes ne le sont pas du tout à court terme. La répartition de la somme de 5 ou 6 dés est très proche d’une loi normale mais pourtant lors du lancement d’un dé, toute les valeurs sont équiprobables …

Les mathématiques ne sont pas en tort. C’est la modélisation initiale du monde réel qui est en tort. Si on sort des hypothèses faites, le modèle ne représente plus la réalité et les résultats n’ont rien à voir avec elle. Il faut bien comprendre que des hypothèses très fortes permettent une modélisation plus puissante donc des résultats plus précis, ce qui intéresse les financiers.

Parfaitement d’accord avec Kafka ! D’ailleurs, il y a une petite erreur dans l’article, l’épistémologie de l’école autrichienne regrette l’induction et non la déduction qui doit partir d’axiomes apodictiques. La physique se base sur des raisonnements parfaitement inductifs…

Mais rejeter sans distinction toute expérimentation mathématique en économie est exagéré”

En cela je ne suis pas d’accord, tenter de modéliser des comportements humains est tout bonnement impossible, car au fond l’economie s’attache à analyser les comportements humains.

Ce serait aussi absurde que de tenter de modéliser l’évolution des sociétés et de prévoir les guerres, les révolutions, les modes à venir avec des équations.

Réponse @ Bubulle

Là encore, je suis d’accord. Je gère un service statistique dans lequel on étudie le comportement du consommateur, la certitude que j’ai pu acquérir c’est qu’on ne peut qu’identifier une tendance, un état à un moment précis, mais les variables explicatives et leurs poids changent tout le temps donc tenter de modéliser les comportements humains n’est pas possible !

@ bubulle : “S’il n’est pas question de modéliser finement les comportements humains, il est possible de s’intéresser à leurs aspects les plus grossiers.”

C’est seulement acceptable pour piloter une activité, réaliser ses arbitrages et ses choix dans le domaine des sciences de gestions, mais il ne faut pas confondre avec la théorie économique qui nous explique l’état des choses en général sans tenir compte du contexte et qui ne tolère pas d’approximation du fait de son caractère englobant et de l’interdépendance des conclusions.

« la vérité est au milieu »

Quel milieu ? Il faut d’abord déterminer les bords extrêmes pour cela, ce qui est difficilement quantifiable et est soumis à l’arbitraire de celui qui les détermine.

Et puis, faut-il prendre en compte de tous les bords ? Comment sait-on que l’on tient compte de tous les bords existants ? Toutes les doctrines possibles sont-elles conceptualisées et finalisées ? Si on peut exclure ne serait-ce qu’un bord, qu’est-ce qui empêche d’exclure les autres bords pour n’en garder plus qu’un ?

Entre les 2 extrêmes d’une politique de génocide et une politique de non-génocide, la vérité du milieu est un demi-génocide ?

Faut-il suivre à l’extrême la voie de la modération ? Si on est modéré de façon modérée, cela signifie que l’on tolère les extrêmes, non ?

N’est-ce pas paradoxal ?

Merci Contrepoints pour ce superbe article!

L’économie comme toute action humaine et plus généralement toute action du vivant est un système à rétroaction non linéaire, c’est à dire que son résultat influe son entrée d’une manière non linéaire. Ce système a en général un comportement chaotique, donc son état précédent ne peut permettre de prévoir l’état suivant. Les travaux de recherche d’ordre dans le chaos, c’est à dire de prévision de l’avenir, ont échoué. Tout système de régulation crée une nouvelle non linéarité donc un résultat encore plus imprévisible. Une des seules solutions pour éviter le comportement chaotique est de mettre en sortie un système de stockage qui, plus il sera important, plus il régulera le système. Pour survivre sans problème, un système monétaire a besoin de réserves (internes ou un crédit stable). C’est comme nous pour notre énergie, il suffit de regarder le stockage sur notre ventre….

Concernant les modèles mathématiques utilisés en économie, il ne faut en effet pas les rejeter en bloc. La microéconomie néoclassique permet d’expliquer, certes de façon grossière, un certain nombre de comportements et peut être appliquer dans de nombreux domaines (je pense aux divers travaux en analyse économique du droit, ou encore à l’énorme œuvre de Gary Becker).

De même, affirmer que les tenants de ces modèles veulent réduire l’action humaine à une formule mathématique est caricatural. C’est simplement un modèle d’étude, qui lorsqu’il est appliqué est d’ailleurs accompagné de la formule “ceteris paribus” (toute chose égale par ailleurs), pour expliciter que les hypothèses sont strictes et pas toujours proches de la réalité.

[je regrette que le traducteur de l’article ait traduit le terme “monnaie-papier” par “monnaie fiat”]

Thomas Mayer évoque l’hypothèse où “la Chine et d’autres grands pays émergents fixent la valeur de leur monnaie sur un panier de biens de consommation”.

C’est une idée très forte. La question d’un étalon de valeur pour la monnaie est un thème difficile du free banking. Et évidement de toute monnaie. A mon avis, lorsque Mayer parle de “panier de biens de consommation”, il ne vise que les marchandises disposant d’un cours mondial. C’est à dire principalement les commodities.

Un panier de commodities est, à plusieurs titres, un étalon de valeur séduisant. Il représente le travail est l’investissement dans de nombreux secteurs de l’activité humaine.

De plus, sur 40 ans, la valeur moyenne des commodities suit les indices de prix à la consommation. A condition d’exclure l’or.

L’or me semble être le pire des étalons de valeur pour une monnaie.