Par Didier Guével.1

Si l’on s’en tient à son étymologie, le mot « robot » se rapporte à une entité anthropomorphe, car ce mot a d’abord été employé pour désigner un automate humanoïde dans une pièce du tchèque Karel Čapek, RUR, les Robots universels de Rossum, créée en 1921. Mais depuis quelques années, le terme est utilisé en des sens bien plus larges.

On parle aujourd’hui de robots pour désigner des machines-outils, des véhicules automatiques, des logiciels d’aide à la décision, des traders automatiques, des drones, des machines chirurgicales, des exosquelettes, voire des téléphones cellulaires (tous ces robots posent, au demeurant, de nombreux problèmes, ne serait-ce qu’en raison de la mémoire externe qu’ils peuvent, peu à peu, devenir pour les individus).

Les « vrais » robots

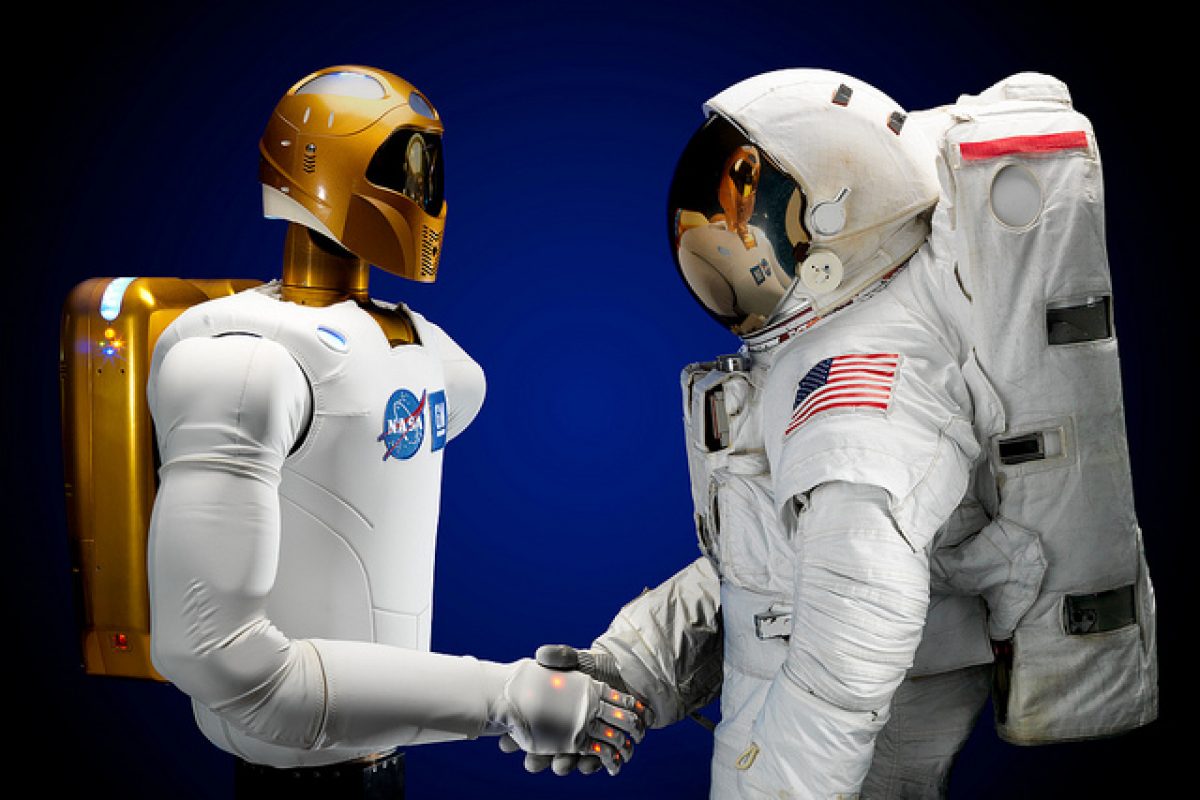

Nous pensons néanmoins qu’il serait préférable de conserver au terme de « robot » un sens plus proche de ses origines, à savoir « celui qui imite le vivant », celui qui désigne un humanoïde (androïde) ou, à la rigueur, un animaloïde, voire un végétaloïde.

C’est, en effet, celui-là qui trouve un écho dans l’inconscient collectif depuis le Golem, celui-là qui a justifié tous les fantasmes, toutes les terreurs, mais aussi de nombreuses créations artistiques.

Certains de ces robots se rapprochent le plus possible de l’apparence humaine ou animale, d’autres s’en éloignent, mais se rattachent à l’aspect humain, comme le font des personnages fictifs de bandes dessinées ou de dessins animés. La confusion n’est pas alors parfaite, mais l’assimilation inconsciente demeure.

Certains n’ont pas d’autre vocation que ludique ; mais beaucoup d’entre eux sont censés réaliser une ou plusieurs actions sociales (aide physique, intellectuelle ou psychologique) aux côtés de l’humain (assistance aux personnes vulnérables, notamment aux personnes âgées, aide à l’éducation des plus jeunes). On parle alors de « robots sociaux », sous-catégorie des robots de service.

La frayeur entretenue

La crainte grandit de voir, peu à peu, des robots s’humaniser en acquérant une intelligence artificielle, interactive et apprenante, tirant des leçons de leur expérience, s’individualisant au fil du temps, voire commençant à contenir des éléments vivants (ordinateur ou éclairage d’origine biologique).

Réciproquement, l’on s’inquiète de la robotisation progressive des humains (prothèses diverses, implants, y compris dans le cerveau). Mais l’idée, à la fois effrayante et séduisante, qu’un jour les deux mouvements pourraient se rejoindre, demeure, en l’état, une fiction. Et le juriste a bien plus à se soucier d’un troisième mouvement, celui de la manipulation du vivant par la génétique.

Le droit, toujours

L’avocat Alain Bensoussan milite de longue date pour que soit conférée aux robots humanoïdes une personnalité juridique, située quelque part entre le statut des meubles protégés (les animaux), celui des personnes morales et celui des personnes physiques.

L’état de la science nous pousse à penser que, pour l’instant, cette approche demeure prématurée.

Qui a vu un match de football « disputé » entre robots humanoïdes comprend que l’on est, non seulement loin de la créature monstrueuse qui risque de détruire son créateur, mais encore loin également d’une entité réellement « pensante ».

Nous n’y croirons que lorsqu’un robot-footballeur sera inculpé à l’occasion d’un match truqué. Nous sommes, pour l’instant, dans le « marionnettisme » évolué et numérisé, pas dans la création divine.

À notre sens, attribuer une responsabilité au robot (fût-il interactif et apprenant), lui accorder un patrimoine, peut paraître, en l’état de la science, infiniment plus anormal que d’accorder pareilles titularités aux animaux dont on sait qu’ils sont considérés comme des biens sensibles.

La question de la responsabilité

L’approche juridique actuelle, face à ces robots qui ressemblent à l’humain et vivent à ses côtés, est, en réalité, probablement, plus simple qu’il n’y paraît. Essentiellement deux questions se posent : celle de la responsabilité et celle du respect de la vie privée.

Quant à la responsabilité contractuelle (au profit des acheteurs ou locataires des robots) la difficulté tient « seulement » en la détermination du responsable : constructeur ou programmateur.

Pour la responsabilité délictuelle (au profit de tiers, victimes d’un préjudice né d’un dysfonctionnement du robot), celle de l’utilisateur final peut, en sus, éventuellement, être recherchée.

Quant au respect de la vie privée, il s’agit de savoir ce que vont devenir les multiples informations que le robot va recueillir sur la personne humaine qu’il côtoie. La question se pose avec encore plus d’acuité si le robot est connecté.

On devrait, juridiquement, savoir résoudre ces problèmes, grâce aux stipulations des contrats (dans lesquels on peut insérer des règles morales, telles les fameuses trois lois d’Asimov) ou par les textes existants tels qu’interprétés par les juges. Faire des lois nouvelles n’est pas toujours indispensable. La spécificité de la matière nous semble résider ailleurs.

Imitation et émotion

L’humain, qui parfois s’éprend de simples objets, est, a fortiori, susceptible de s’attacher à un robot humanoïde ou animaloïde.

Il va en conséquence lui prêter des sentiments réciproques, alors que le robot ne fait que singer, qu’imiter l’humain, par des sons, des gestes, ou des mouvements du « visage », attitudes programmées face à telle parole ou tel signe, qu’il est appelé à reconnaître grâce à ses capteurs sonores ou visuels.

L’expression d’« intelligence artificielle » est, pour l’instant, trompeuse ; le robot n’est pas intelligent au sens humain, surtout si l’on accepte l’idée que l’intelligence est de l’ordre de la génétique ; s’il s’agit bien de raisonnements, même de plus en plus sophistiqués (on songe à la victoire d’AlphaGo au jeu de go), si le robot dispose de couches successives de silicium de plus en plus nombreuses, d’une mémoire autobiographique, il ne comprend pas pour autant, il n’a pas conscience de ce qu’il fait.

De plus, il lui manquera toujours l’élément sentimental, la souffrance, le plaisir et les imperfections, qui sont à la fois un inconvénient (l’humain peut commettre plus de fautes que le robot et il peut avoir moins de capacités sensorielles), mais aussi une formidable différence en termes d’empathie, de solidarité du vivant et d’adaptabilité aux imprévus de l’environnement et de l’évolution.

Et c’est bien cette différence psychologique fondamentale que le juriste devrait intégrer dans son raisonnement lorsqu’il va chercher à appliquer les principes juridiques fondamentaux ou à rédiger des conventions.

—

Sur le web![]() -Article publié sous licence Creative Commons CC BY-ND 4.0.

-Article publié sous licence Creative Commons CC BY-ND 4.0.

- Professeur de droit privé et sciences criminelles, Université Paris 13 – USPC. ↩

Restreindre les robots et les problèmes de droits de ceux-ci, uniquement aux androïdes et animaloïdes est restrictifs. Le problème du véhicule “intelligent” relève bien des mêmes interrogations.

Lorsqu’un véhicule doit choisir entre protéger son conducteur en tuant des piétons ou le contraire, il y a bien un problème légal (même s’il me parait évident qu’un constructeur ne pouvant s’engager qu’envers son client, devra privilégier celui-ci. Sauf loi générale).

D’autre part, dans le cas du deep-learning, il n’y a plus de programmeur responsable, et la responsabilité est diluée entre le constructeur qui a donné au robot des capacités d’apprentissage et l’utilisateur qui, par “l’enseignement” qu’il lui dispense va déterminer les actions futures de ce robot.

Ainsi donc, avant de parler de droits des robots, il semble judicieux de parler des devoirs de ceux-ci et de responsabilité des constructeurs et propriétaires.

@jesuisunhommelibre: Plutôt que d’androïdes ou de véhicules intelligents, le vrai problème que l’article néglige totalement est celui de l’autonomie dans le cas d’un robot.

Si le robot n’est pas autonome, on en revient aux mêmes problèmes de droit qu’un serveur informatique.

S’il est autonome, la responsabilité n’est plus déléguée, et là se pose la question non plus des simples objectifs du robot, mais de sa finalité : sa tâche à-t-elle une fin, un cycle, s’améliorer ou s’arrêter pour constater, etc…

Dans le cas des expériences morales où le conducteur doit choisir dans des situations impossibles, on constate qu’en moyenne les différences d’actions sont d’abord dû aux règles morales en vigueur dans la société d’origine.

L’individu agit comme il pense que la société le jugerait : il se déresponsabilise. En gros, il se place dans la situation d’un robot pre programmé.

NB: Un robot totalement autonome se reproduirait, donc serait vivant, donc en lutte avec son environnement…

Le soit-disant dilemme de sauver le conducteur ou les pietons est un faux debat. La voiture ne doit pas se mettre dans une situation ou un tel dilemme se presenterait. Et meme si c’est le cas, si les pietons sont la ou ils ne devraient pas etre, il n’y a pas de raison de mettre en danger le ‘conducteur’.

Actuellement, le deep learning est fait par le constructeur (et non le client), avec toute une batterie de test apres apprentissage. Le but est de couvrir le plus de cas possible pour ne pas avoir de surprise.

Si a l’avenir, les algos sont suffisamment bien maitrises au point que l’apprentissage peut se faire par le client, je pense que la situation deviendra similaire a la personne qui achete un chien et qui a la charge de l’eduquer correctement et est responsable de tout probleme qui pourrait survenir.

Donc le robot démineur a un droit de retrait !

Et encore un confond “Intelligence Artificielle” et “Conscience Artificielle” !

Cherchez la différence entre intelligence artificielle et conscience artificielle.

Je cite l’auteur : “De plus, il lui manquera toujours l’élément sentimental, la souffrance, le plaisir et les imperfections, qui sont à la fois un inconvénient (l’humain peut commettre plus de fautes que le robot et il peut avoir moins de capacités sensorielles), mais aussi une formidable différence en termes d’empathie, de solidarité du vivant et d’adaptabilité aux imprévus de l’environnement et de l’évolution.”

Quand on a bien compris que 100% de nos émotions les plus humaines sont liées directement à des sécrétions hormonales, on en relativise le côté précieux, exceptionnel, quasi divin. Et on comprend bien que dans un proche avenir (quelques années à quelques décennies seulement) des bases techniques comparables pourront être intégrées dans des robots rendus ainsi encore plus autonomes, plus complets.

L’anthropocentrisle fait penser à certains que l’Homme est inimitable. Pour peu que ces penseurs soient versés dans une foi religieuse on touche alors à un domaine exclus du domaine de l’envisageable.

Mais l’évolution de la pensée et de la technologie ne saurait s’arrêter à cette difficulté conceptuelle.

Le robot qui est conscient de lui-même et de son environnement, qui dispose de sa propre éthique, qui fait évoluer ses propres concepts moraux est déjà prévisible. La question n’est pas de savoir si c’est possible, mais simplement de se demander “quand” ce sera réalisé.

Il reste du temps aux juristes pour se forger une meilleure culture technologique, mais le temps file vite…

Vous avez raison sur les futures possibilités techniques d’intégration d'”émotions” dans des robots. Mais alors que ces fonctions chez l’Homme on été construites lors que l’évolution, et dans un environnement particulièrement dangereux, les robots n’auront aucun besoin d’intégrer la plupart de celles-ci, l’environnement auquel ils seront confrontés n’ayant rien à voir avec celui des 50 000 ans qui nous ont construits. Ils ne devront jamais avoir à survivre en chassant ou en échappant à un tigre-sabre, et ils ne seront pas en quête permanence de nourriture. Les notions de survie et de perpétuation de l’espèce, qui sont les moteurs principaux (pour ne pas dire uniques) des agissements humains, ne concerneront pas les robots.

Ceci devrait rassurer tout ceux qui semble redouter la venue de la singularité de l’intelligence artificielle.

L’Homme bicentenaire d’Asimov traite de ce sujet

– Année 1266. — Pourceau brûlé à Fontenay-au:-Roses, près Paris, pour avoir dévoré un enfant.

– Septembre 1394. — Porc pendu à Mortaing, pour avoir tué un enfant de la paroisse de Roumaigne.

– Année 1404. — Trois porcs suppliciés à Rouvres, en Bourgogne, pour avoir tué un enfant dans son berceau.

– 17 juillet 1408. — Porc pendu à Vaudreuil pour un fait de même nature, conformément à la sentence du bailly de Rouen et des consuls, prononcée aux assises de Pont de-l’Arche tenues le 13 du même mois.

– 24 décembre 1414. — Petit pourceau traîné et pendu par les jambes de derrière, pour meurtre d’un enfant, suivant sentence du mayeur et des échevins d’Abbeville.

– 14 février 1418. — Autre pourceau coupable du même fait et pendu de la même manière, en vertu d’une sentence du mayeur et des échevins d’Abbeville.

Il va falloir des potences solides pour pendre les voitures qui écrasent des piétons !